Os bombas detonadas durante a maratona de Boston oferecem um lembrete austero das falhas de Análise do Big Data e de Segurança, notoriamente as agências de inteligência foram incapazes de ligar os pontos antes e depois dos ataques 15 de abril.

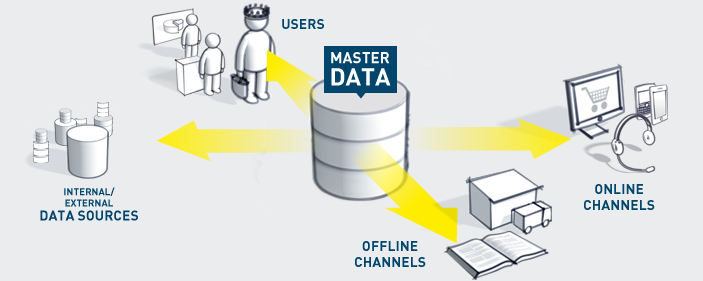

A falta de compartilhamento de informações entre as organizações e unidades de negócios, ou a consciência de que um determinado conjunto de dados ainda existe, é um problema comum. Análises de Big Data podem ajudar a resolver este dilema, de acordo com seus proponentes, e fornecer dados de inteligência que detecta padrões suspeitos e ameaças potenciais, expandindo a definição de dados de segurança para todas as partes do negócio.

Segurança orientada a inteligência alimentada por análises de Big Data vai atrapalhar vários segmentos de produtos nos próximos dois anos, de acordo com executivos da RSA, a divisão de segurança da EMC. "Com a difusão de Big Data cobrindo tudo o que fazemos", disse Arthur Coviello, Jr., vice-presidente da EMC e presidente executivo da divisão de segurança RSA , durante sua palestra RSA, em fevereiro, "a nossa superfície de ataque está prestes a ser alterada e expandir , e os nossos riscos ampliados de forma que não poderíamos ter imaginado. "

|

Arthur Coviello, Jr., vice-presidente da EMC e

Presidente Executivo da Divisão de Segurança RSA |

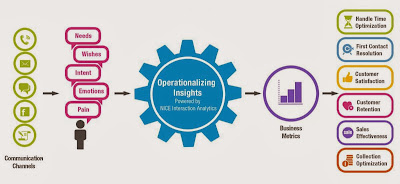

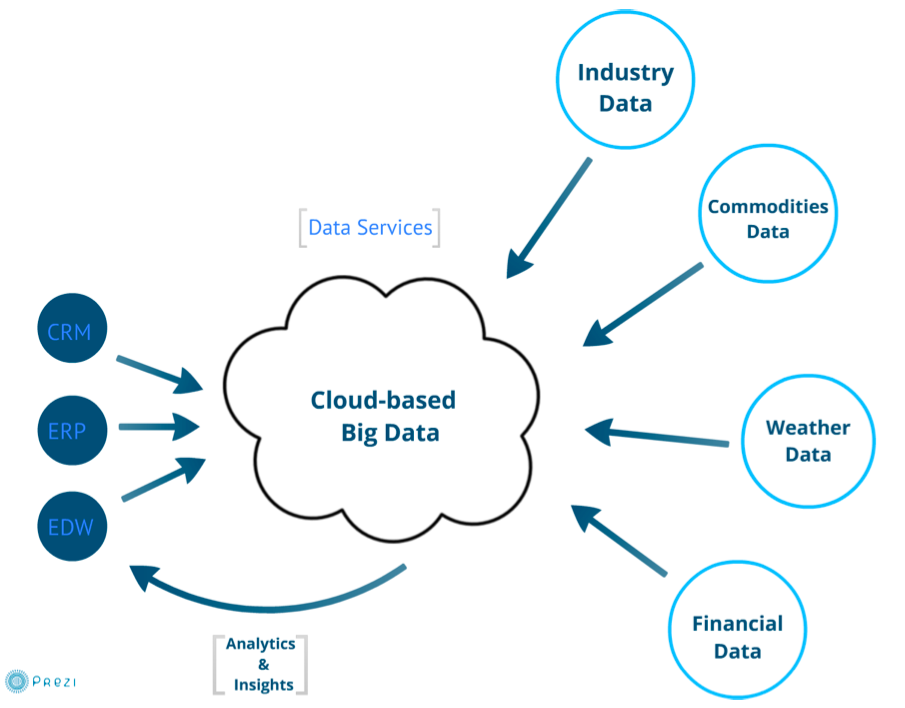

Como as organizações e funcionários cada vez mais operando em ambientes móveis, web e mídia social, aproveitando-se de informações identificadas por análises ou padrões através de uma ampla variedade de conjuntos de dados, incluindo texto não estruturado e binário de áudio de dados, imagens e vídeo podem oferecer informações valiosas sobre negócios riscos muito além de TI.

Mas, mesmo com o uso de modelagem estatística avançada e análise preditiva, as ameaças à segurança de origens desconhecidas ainda podem passar despercebidas. Será que o Big Data e análises de alto desempenho realmente podem fazer segurança melhor? Talvez, mas hoje o uso significativo de tecnologias de Big Data em grandes volumes de dados de segurança é rara e extremamente desafiador, de acordo com Anton Chuvakin, diretor de segurança e gestão de risco, o Gartner, brincou com a pesquisa: "As organizações que usam análise preditiva tradicionais para a segurança ? Você quer dizer "os dois? '"

O Gartner define "big data", baseado nos 3Vs (Volume, Variedade e Velocidade).

|

| Anton Chuvakin |

"As organizações que realmente investiram tempo (muitas vezes anos) e recursos (muitas vezes milhões de dólares) na construção de sua própria plataforma para big data analytics têm encontrado valor", disse Chuvakin. "Normalmente, esse valor se manifesta através de uma melhor detecção de fraudes, detecção de incidentes de segurança mais ampla e profunda tornando a investigação de incidentes mais eficaz."

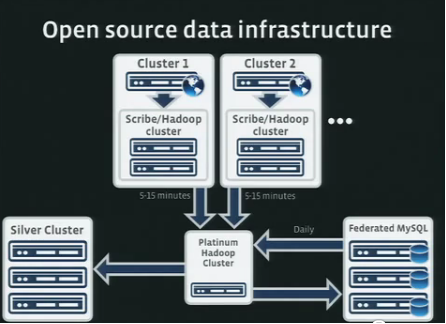

Uma dessas empresas é a Visa, a gigante em processamento de cartão de crédito. A empresa fez um respingo no início deste ano, quando se divulgou no The Wall Street Journal que ele estava usando um novo mecanismo de análise e 16 modelos diferentes, que pode ser atualizado em menos de uma hora, para detectar a fraude de cartão de crédito. Steve Rosenbush do The Journal blogged sobre as melhorias por trás do mecanismo de análise de alto desempenho, que de acordo com a Visa, ela monitora e acompanha até 500 aspectos de uma transação, em comparação com a tecnologia anterior, que só poderia lidar com 40. As capacidades de análises poderosas são possíveis em parte pela adoção da tecnologia de banco de dados não-relacional em 2010 e pelo framework open source software Apache Hadoop, que é projetado para o armazenamento de baixo custo e cálculo de dados distribuídos através de clusters de servidores de commodities da Visa.

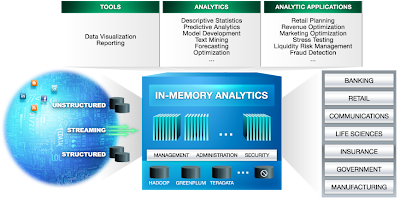

A CORRIDA PARA GRANDES ANÁLISES

Apesar de toda a polêmica sobre o Hadoop, que utiliza o modelo de programação MapReduce (derivado da tecnologia do Google) para "mapear" e "reduzir" de dados, juntamente com um sistema de arquivos distribuídos (HDFS) com built-in de automação para falhas e redundância,o uso de Hadoop é rara em grandes e médias empresas. As ferramentas para acessar o armazenamento do Hadoop e capacidades computacionais são ainda imperceptíveis, sem interfaces, com ferramentas complexas para os cientistas de dados ou acesso programático para programadores qualificados com conhecimento de MapR Hive para consultas SQL-like ou Pig para alto nível de fluxo de dados.

Isso pode mudar em breve, no entanto, como os fornecedores de tecnologia de todas as empresas de infra-estrutura de todos os lados e grandes empresas de software prestadores de serviço na tentativa de fornecer grandes ferramentas de análise de dados (Big Data Analytics Tools)para usuários corporativos. A Cloudera, oferece uma distribuição para Hadoop (CDH) e a SAS anunciou uma parceria estratégica para integrar SAS High Performance Analytics e SAS Analytics Visual entre outras ferramentas no final de abril. Infobright, Greenplum da EMC e MapR estão se movendo para o espaço empresarial com análises e ferramentas de visualização que permitem aos analistas corporativos trabalhar com grandes conjuntos de dados e desenvolvimento de processos analíticos, em alguns casos usando sandboxing e virtualização.

"Esse tipo de análise vendo sendo necessária ha muito tempo e apenas agora as tecnologias que podem realmente realizar esse tipo de análise em grandes escalas será disponibilizada ", disse Mark Seward, diretor sênior de segurança e conformidade em Splunk. Informações de segurança das empresas e gerenciamento de eventos de tecnologia (SIEM) já é utilizado por cerca de 2.000 empresas para analisar os dados da máquina, o que inclui todos os dados de sistemas, a "Internet das coisas" e os dispositivos conectados.

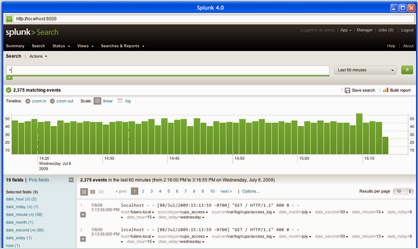

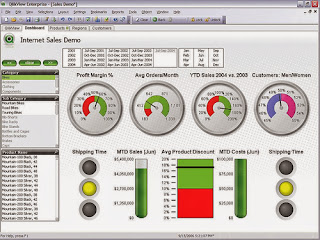

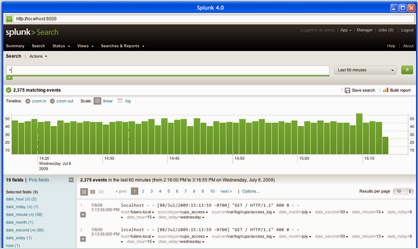

Qualquer texto ACSII podem ser indexados pelo Splunk, que por sua vez pode usar até 150 comandos sobre os dados de retorno definidos para realizar a análise estatística e disponibilizar visualizações. De acordo com Seward, o Splunk pode ser escalado para petabytes de dados. Ele não lida nativamente com dados binários mas o Hadoop e outros conversores estão disponíveis. Para usar o Splunk, os profissionais de segurança de TI essencialmente precisam entender e conhecer comandos shell script Unix, SQL e ter acesso à documentação sobre o tipo de campos que têm nos dados.

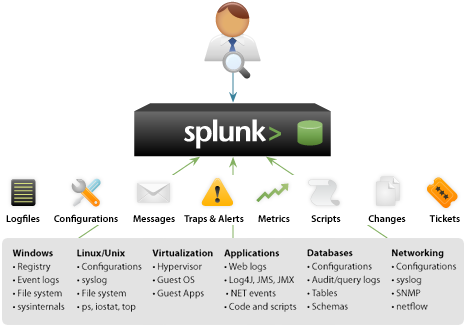

O que é o Splunk?

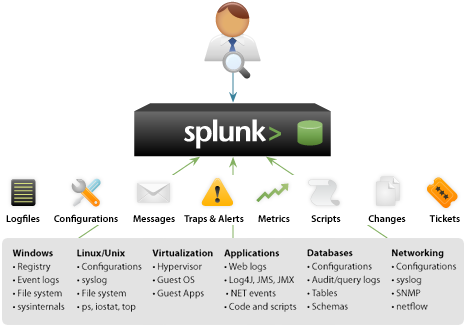

Splunk é uma ferramenta de pesquisa e analise de logs de TI. É um software que permite que você indexe, pesquise, alerte e informe em tempo real e permite que você visualize históricos de dados de TI – dando uma maior visualização em toda a sua infra-estrutura de TI de uma localidade em tempo real. Reduza o tempo para solucionar problemas de TI e incidentes de segurança para minutos ou segundos ao invés de horas ou dias. Monitore toda sua infra-estrutura de TI para evitar degradação do serviço e tempo de inatividade. Relatórios sobre todos os controles de sua conformidade a um custo menor e em uma fração do tempo. O download do Splunk gratuito.

Splunk indexa qualquer tipo de dado de TI de qualquer fonte em tempo real. Aponte seus servidores syslog ou dispositivos de rede para o Splunk, configure sondagens de WMI, monitore arquivos de log em tempo real, permitir a monitoração das alterações em seu sistema de arquivos ou o registro no Windows, ou até mesmo agendar um script para pegar as métricas do sistema. Splunk indexa todos os seus dados de TI sem precisar de nenhum analisador especifico ou adaptadores para compra, escrever ou manter. Tanto os dados primários e o rico índice são armazenados em um eficiente, compacto, armazenamento de dados baseado em arquivos com assinatura de dados opcionais e auditoria da integridade de dados.

"Com o advento do Hadoop e tecnologias de indexação como Splunk, agora as tecnologias estão disponíveis para dar uma olhada com mais detalhes em torno de dados gerados por máquina e os dados gerados por usuários para entender o que está acontecendo dentro de uma organização, ou o que está acontecendo dentro de uma linha de produção, por exemplo ", disse Seward. Quando você pensa sobre o risco em toda a organização, você não está apenas pensando em segurança, no sentido tradicional, mas você também está pensando sobre o que as pessoas fazem no dia-a-dia em todos os dados ou o máximo que puder obter. o que seria um risco para o seu negócio particular. "Eu talvez precise olhar para os dados de aquecimento e ventilação para entender se alguém entrou na fábrica e alterou a temperatura de alguns graus, o que poderia colocar em risco toda a produção de um produto", disse ele.

.jpg)

.jpg)